Imprimantes 3D,

une nouvelle révolution industrielle

est en marche !

Un peu d'histoire...

La première version de cette technologie de fabrication additive est apparue dès la fin des années 1970 avec les travaux du chercheur japonais Dr Hideo Kodama. Ce dernier inventa une technique d’impression par couches en utilisant la lumière ultraviolette pour durcir les polymères photosensibles.

En 1983, ce principe, va inspirer Charles Hull, un ingénieur américain, qui travaille dans le moulage de prototype en plastique destiné au milieu médical. Son premier prototype, alliant lumière UV et plastique, est une œillère, destinée aux opticiens. L'idée de base est de réaliser un objet via le dépôt successif de plusieurs couches de résine, puis la polymérisation de celles-ci va les UV. Le procèdé est baptisé stéréolithographie. Seul problème, l’extrême lenteur du processus, fait qu'un objet réalisé de cette manière, prendra plusieurs jours. Et pourtant, le procédé de l'impression 3D (malgré l'évolution des techniques) reste identique de nos jours.

Le 16 Juillet 1984, trois Français déposent un brevet concernant un procédé de fabrication additive pour la société CILAS ALCATEL. Les trois chercheurs ne seront pas pris au sérieux, car les dirigeants de l'époque ne voient aucun débouché commercial pour cette invention, ce qui mettra un terme au projet. Trois semaines plus tard, Charles Hull dépose le brevet de sa technique de stéréolithographie (nom à l'origine du format .stl), et fonde la société 3D system, qui lance et commercialise, la première vraie imprimante 3D industrielle (la SLA 1) 4 ans plus tard, en 1988.

3D system est aujourd'hui le leader mondial de conception et fabrication d'imprimantes 3D, en 2014 elle annonçait un chiffre d'affaire de 700 millions de dollars.

Alain Le Méhauté, l’un des pères français de l’impression 3D, déclare dans un article paru en 2014 :

« …durant 15 années je me suis heurté entre autres aux notables et à la commission des titres d’ingénieur, qui ont tout fait pour casser la dynamique d’innovation… »

http://www.primante3d.com/inventeur/

En 2015, de nombreux observateurs estiment que ces technologies prendront une part importante dans la nouvelle forme de production.

Impression 3D, les différents procédés.

Il existe trois grandes techniques de base concernant la réalisation d'objets en 3D :

- La Stéréolithographie (SLA),

- le dépôt de matière en fusion (Fused Deposition Modeling – FDM)

- Le forgeage par application laser (Selective Laser Sintering – SLS).

La Stéréolithographie

Breveté par Charles Hull, aux états unis, et Alain le Méhauté, avec ses collègues, en France.

Une des formes de la Stereolythographie la plus répandue est la Photopolymérisation (SLA) : on concentre un rayon ultraviolet dans une cuve remplie de photopolymère (un matériau synthétique dont les molécules se modifient sous l’effet de la lumière, la plupart du temps ultraviolette). Le Laser ultraviolet travaille le modèle 3D souhaité couche après couche.

Quand le rayon frappe la matière, cette dernière se durcît sous son impact tout en se liant aux couches adjacentes. Au sortir de la cuve, on obtient une forme à la résolution remarquable et, cerise sur la gâteau, la matière non frappée par le laser peut être utilisée pour le prochain objet.

L’imprimante 3D grand public la plus connue utilisant ce procédé est FormLabs.

Mais on doit à la "Stereolithography" autre chose : c’est le fameux format .stl qui est actuellement le format numérique en passe de devenir le standard dans le monde de l’impression 3D.

Fused Deposition Modeling (FDM)

Ce procédé a été inventé par Scott Crump à la fin des années 80 pour voir la première sortie commerciale du procédé en 1991.

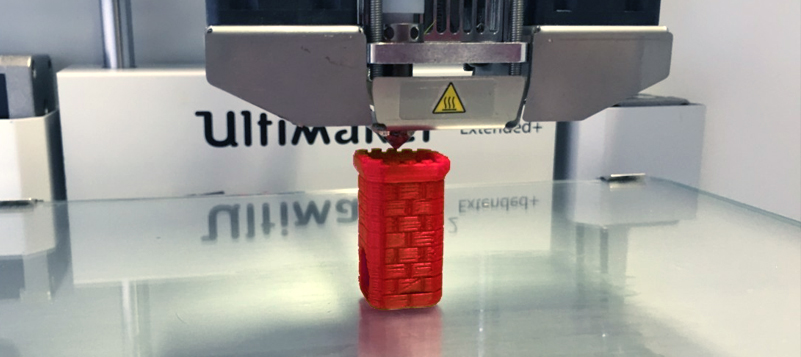

Le FDM consiste à porter à la fusion de petites gouttes de matière plastique (Souvent le plastique de type ABS –celui des lego™-) qui créent la forme couche après couche. Une fois que la goutte quitte l’applicateur, elle durcît de manière quasi-immédiate tout en se fondant avec les couches inférieures. C’est le procédé de loin le moins coûteux et c’est sur lui que se reposent aujourd’hui la grande majorité des imprimantes 3D grands publics. Outre le plastique ABS, les plastiques PLA (Polylactic Acid) et d’autres polymères biodégradables peuvent être travaillés depuis ce procédé.

La plupart des imprimantes 3D « abordables » parmi les plus connues utilisent ce procédé notamment celles à l’initiative de RepRap, Solidoodle, LeapFrog, MakerBot ou l’imprimante CubeX.

Une variante existe sous le nom de Plastic Jet Printing (PJP) : il concerne l’ensemble des imprimantes résolument grand public comme la Cube.

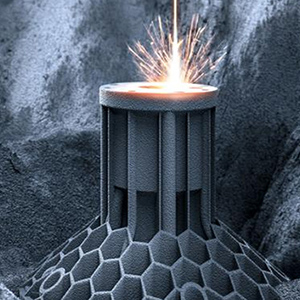

Selective Laser Sintering (SLS)

On attribue l’invention de ce procédé à Carl Deckard et Joe Beamanand, chercheurs à l’Université d’Austin, au milieu des années 80.

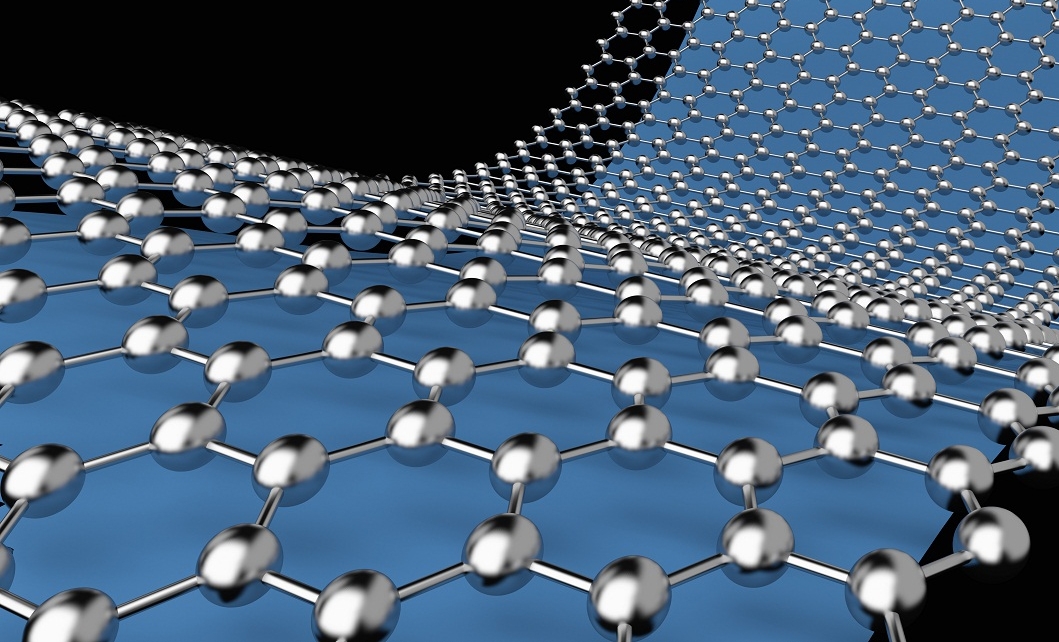

Cette technologie est proche de la Stéréolithographie mais sans la cuve remplie de polymère. Des matières dures (sous forme de poudre) comme le polystyrène, le verre, le nylon, certains métaux (dont le titane, l’acier ou l’argent) ou de la céramique sont frappées par un laser. Là où le laser frappe, la poudre s’assemble pour créer la forme. Toute la poudre non frappée peut être réutilisée pour les prochains objets à imprimer.

L’imprimante la plus connue utilisant ce procédé est la SinterStation Pro SLS 3D printer (Imprimante 3D professionnelle)

Un marché en plein essort

Selon IDC, le marché mondial des imprimantes 3D, services et matériaux associés devrait connaître une forte hausse en 2019, pour atteindre 13,9 milliards de dollars US. En se basant sur un taux de croissance sur cinq ans de 19,1%, le marché devrait avoisiner 22,7 milliards de dollars en 2022.

D’après ces prévisions, les imprimantes 3D et les matériaux associés (plastiques, métaux, résines) devraient représenter des dépenses de 5,3 milliards de dollars et 4,2 milliards. Les services seront un peu à la traîne, avec un montant total autour de 3,8 milliards.

Trois secteurs porteurs de la croissance :

L'industrie, assure plus de la moitié des dépenses dans le domaine.

L’augmentation rapide des vitesses de production, ainsi que des avancées majeures au niveau des matériaux utilisés pour l’impression 3D, permettent à ces technologies de répondre à un plus large spectre d’applications. De ce fait, les industriels ont dépassé le stade du prototypage, et commencent à produire de petites séries grâce à ce procéder.

La médecine, 1,8 milliard de dollars de dépenses en 2019.

Avec la montée en puissance du secteur de la santé, la fabrication d’objets pour les soins dentaires et le support médical arrivent en troisième et quatrième position, suivis par les outils spécialisés. Les taux de croissance les plus élevés devraient s’observer dans l’impression de matériaux biologiques, comme les tissus, organes et os (TCAC de 42,9%), ainsi que sur les prothèses dentaires (TCAC de 33,1%).

L'éducation et la recherche, 1,2 milliard de dollars.

En 2010, Urbee a été la première voiture créée grâce à l’impression 3D. Sa structure principale a été totalement imprimée en 3D, grâce à l’usage d’une imprimante 3D très large. Encore maintenant, la voiture imprimée en 3D est toujours considérée plus comme un rêve que comme une réalité, pourtant, de nombreux acteurs considèrent l’impression 3D comme une bonne alternative aux méthodes traditionnelles de fabrication.

En 2011, Cornell University a commencé à fabriquer une imprimante 3D pour les denrées alimentaires.

En 2014, la NASA a amené une imprimante 3D dans l’espace afin de créer le premier objet imprimé en 3D hors de la Terre.

L'agence spatiale recherche par ailleurs un moyen pour imprimer des aliments en 3D dans l’espace.

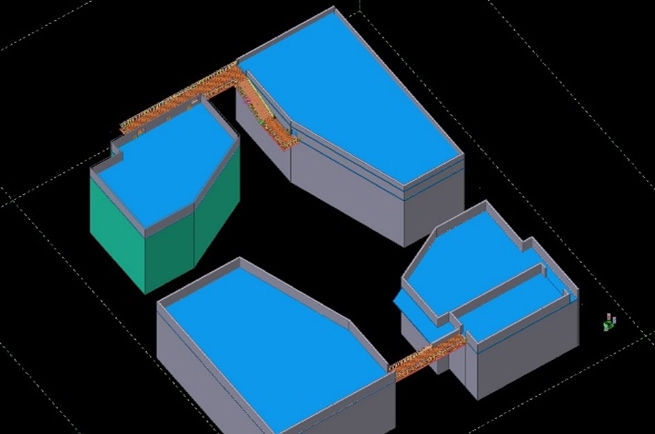

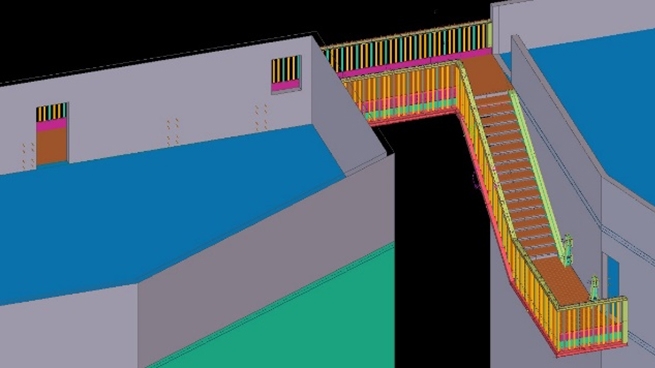

Quelles perspectives d'avenir ?

les secteurs de la recherche sont plus que jamais, impliqués dans le développement de systèmes d’impression 3D

L'impression 3D a fait son entrée dans le monde industriel depuis déjà des années pour réaliser des prototypes. Et puis, elle s’est invitée dans la sphère privée, permettant à tout un chacun de réaliser ses propres pièces. Les matériaux de fabrication, quant à eux, sont encore majoritairement limités à la résine, aux plastiques, aux polymères et certains produits alimentaires. Depuis peu, il est possible d’imprimer des petites pièces, avec du métal.

Les progrès avancent de jours en jours, et avec eux les possibilités de fabriquer des objets de plus en plus complexes avec un degré de finition de plus en plus élaboré.

Même si il reste à faire de très grands progrès, l’impression 3D est porteuse de promesses dans les secteurs de la production industrielle, comme chez les particuliers. Par ailleurs, le fait que certains brevets liés à cette technologie soient tombés dans le domaine public, va accélérer les initiatives.

Barack Obama lance à partir de 2013 plusieurs centres de recherches sur le sujet, l’objectif pourrait être de concurrencer de nouveau les marchés émergents comme la Chine, imbattables pour le moment pour ce qui concerne les produits simples et répétitifs, produits à très bas coût. L’économie du transport permettrait de rendre de nouveau viable la production locale grâce à ce type de machine. C’est encore du domaine de la théorie, mais les perspectives sont plus que motivantes. Et Obama l’affirmait lui-même dans des propos repris par Libération :

Cet institut permettra de s’assurer que les emplois industriels de demain ne soient plus en Chine ou en Inde, mais ici, aux Etats-Unis.

Il est donc devenu évident que cette technologie, lorsqu’elle sera mature, va vraiment apporter de gros changements dans tous les secteurs industriels. On voit ainsi déjà se monter des fermes d'imprimantes 3D dédiées à la fabrication d'articles personnalisés de petite et moyenne série. Certaines marques de luxe notamment ont déjà opté pour l'impression 3D pour certains articles, notamment des montures de lunettes. Plus qu'un simple outil permettant de reproduire une pièce cassée à l'identique, l'impression 3D pourrait révolutionner notre rapport à la consommation et participer activement à la lutte contre l'obsolescence programmée.

Et la France ?

Loin de l'époque des années 80 (et des difficultés des pionniers de l’impression 3D, à faire entendre leurs voix quant à la nécessité d'entreprendre des recherches dans le domaine), nous sommes passés aujourd'hui dans une toute autre époque.

Face aux innovations venues d'outre atlantique, les grands acteurs de l'industrie française, l'ont bien compris cette fois : Il n'est plus question de rater le coche comme il y a plus de trente ans. Reste qu'en France, il faudrait faire émerger un marché de la fabrication additive, comme le souligne Olivier Dario (SYMOP), dans un article de l'Usine nouvelle .

Il faut travailler sur les normes, notamment de sécurité et sur les matériaux, c’est l’un des grands chantiers de l’impression 3D. Il faut que les technologies soient plus robustes, aujourd’hui les machines ont encore du mal à répliquer la même pièce. Et il faut développer les cas d’usages pour créer une demande. Les cas d’usages sont encore trop peu nombreux.

La nécessité de ne pas se retrouver distancés par les pays qui investissent le plus sur ces technologies (comme les USA ou encore la Chine), est impérieuse. En France certaines grosses industries utilisent ce procédé de fabrication, mais afin de rester concurrentiels face aux géants d'outre atlantique, il faudrait créer une véritable filière de l'impression 3D.

Crédits photos : Public domain images, freestock photos, fotolia